Megatron-Turing Natural Language Generation (MT-NLG) modeli, 2021 yılında Microsoft ve NVIDIA'nın ortak çalışmaları sonucunda geliştirilmiştir. Yapay zekâ ve derin öğrenme alanında iki devin güçlerini birleştirmesi, dil modelleme alanında en gelişmiş modellerden birini ortaya çıkarmıştır. Bu model, doğal dil işleme (NLP) teknolojilerinde sınırları zorlayan ve birçok dil görevini yüksek başarı oranlarıyla yerine getiren bir yapıdadır.

Yapay zekâyı doğallaştıran sistem: Doğal Dil İşleme (NLP)

Yapay zekâyı doğallaştıran sistem: Doğal Dil İşleme (NLP)

MT-NLG’nin kökeni, NVIDIA’nın geliştirdiği Megatron-LM ve Microsoft’un Turing NLG modellerine dayanır. Megatron-LM, çok büyük dil modelleri eğitmek için kullanılan bir yapıdır ve özellikle büyük veri kümeleri üzerinde optimize edilmiştir. Turing NLG ise, Microsoft’un dil işleme teknolojilerinde önceki yıllarda büyük başarılar elde ettiği bir modeldi. İki devin bu alandaki birikimlerini birleştirmesiyle, MT-NLG, 530 milyar parametreyle bugüne kadar oluşturulmuş en büyük dil modellerinden biri olarak tarih sahnesine çıkmıştır.

GELİŞİM SÜRECİ VE YÜKSEK PERFORMANS

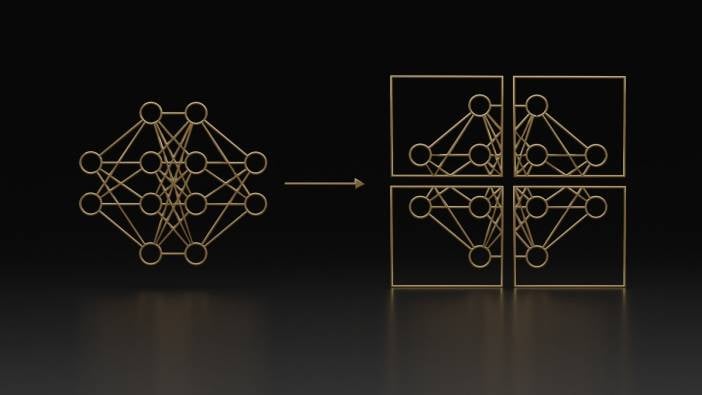

MT-NLG’nin gelişiminde temel amaç, büyük dil modellerinin kapasitesini artırarak, daha geniş ve karmaşık görevleri başarıyla yerine getirebilecek bir yapı inşa etmekti. Dil modelleri, parametre sayısı arttıkça genellikle daha güçlü bir hale gelir. Bu parametreler, bir yapay sinir ağının öğrenme sürecinde kullandığı ağırlıkları ifade eder. Megatron-Turing NLG, önceki modellerin aksine, devasa veri kümeleri üzerinde eğitilerek dilin anlamını daha derin bir şekilde kavrayabilecek bir yapı haline getirildi.

530 milyar parametreye sahip olması, bu modelin karmaşık dil görevlerinde diğer modellere kıyasla çok daha başarılı olmasını sağlar. Bu parametrelerin bu kadar yüksek olmasının nedeni, büyük veri kümeleri üzerinde öğrenme yaparak daha geniş bir dil çeşitliliğini anlaması ve bu sayede insan benzeri metinler üretebilmesidir. Dil modelleri genellikle ne kadar büyük olursa, o kadar daha anlamlı ve doğru sonuçlar verir. MT-NLG de bu trendin bir devamı olarak gelişmiştir.

Eğitim süreci sırasında, modelin performansını artırmak için Dağıtılmış Öğrenme ve Model Paralelleştirme gibi teknikler kullanıldı. Bu teknikler sayesinde, model devasa veri kümelerini daha hızlı ve etkili bir şekilde işleyebilir hale geldi. NVIDIA’nın gelişmiş GPU teknolojileri, bu büyük modellerin eğitimi için kritik bir rol oynadı. Microsoft’un Azure bulut altyapısı da, modelin öğrenme sürecinin yüksek verimlilikle gerçekleştirilmesine olanak tanıdı.

ÇALIŞMA PRENSİPLERİ

MT-NLG, derin öğrenme yöntemlerine dayanan bir dil modelidir ve temelde dil modelleme ve doğal dil üretimi üzerine yoğunlaşır. Model, önceki dil modellerine kıyasla çok daha büyük bir veri seti üzerinde eğitildiği için dilin yapısını, dil bilgisi kurallarını ve anlamını derinlemesine kavrayabilir. Bunun yanı sıra, modelin otoregresif bir yapısı vardır, yani bir metni kelime kelime tahmin eder ve her yeni kelimeyi üretirken önceki kelimeleri dikkate alır.

Modelin eğitimi sırasında kullanılan veri setleri oldukça geniş bir yelpazeyi kapsar. Kitaplardan, haberlerden, bilimsel makalelerden ve internet kaynaklarından toplanan bu veri setleri, modelin farklı dil kullanımlarını ve tarzlarını öğrenmesini sağlar. Bu sayede MT-NLG, bir metin oluştururken belirli bir konuya ya da dile özgü incelikleri de kavrayabilir.

MT-NLG, Transformer mimarisi üzerine inşa edilmiştir. Transformer mimarisi, doğal dil işleme modellerinin en yaygın kullanılan yapısıdır ve özellikle dikkat mekanizması (attention mechanism) sayesinde metinler arasındaki bağlam ilişkilerini anlamada oldukça başarılıdır. Bu mekanizma, metnin belirli bir bölümüne odaklanarak, kelimeler arasındaki ilişkileri daha iyi kavramaya yardımcı olur. Bu sayede, MT-NLG hem kısa hem de uzun metinler üretebilirken anlam bütünlüğünü koruyabilir.

Google'ın yapay zekâ devrimi: Transformer algoritması

Google'ın yapay zekâ devrimi: Transformer algoritması

Dikkat Mekanizması: Yapay zekânın dönüşüm noktası

Dikkat Mekanizması: Yapay zekânın dönüşüm noktası

KULLANIM ALANLARI VE POTANSİYELİ

MT-NLG, birçok farklı alanda kullanılma potansiyeline sahiptir. Bu modelin en dikkat çekici kullanım alanlarından biri, otomatik metin oluşturmadır. Haber yazma, içerik üretme, senaryo yazma gibi yaratıcı süreçlerde bu model, insanlara yardımcı olabilir. Özellikle gazetecilik ve dijital pazarlama gibi alanlarda, büyük ölçekli içerik üretimi için bu tür modellerin kullanımı artmaktadır.

Bir diğer kullanım alanı ise sohbet robotları (chatbot) ve dijital asistanlardır. MT-NLG’nin insan benzeri metinler üretebilme yeteneği, bu tür yapay zekâların daha doğal ve etkili bir şekilde insanlarla iletişim kurmasını sağlar. Müşteri hizmetleri, sağlık hizmetleri gibi alanlarda, MT-NLG tabanlı çözümler, kullanıcı deneyimini iyileştirmek için kullanılabilir.

Ayrıca, çeviri sistemleri, özetleme ve dil anlama gibi diğer NLP görevlerinde de MT-NLG’nin yüksek başarı oranlarına ulaşması beklenmektedir. Modelin derin dil bilgisi ve geniş dil çeşitliliği, çok dilli projelerde ve karmaşık dil yapılarını anlamada önemli bir avantaj sağlar.

GELECEK BEKLENTİLERİ

MT-NLG’nin gelişimi, dil işleme teknolojilerinin gelecekte nasıl evrileceğine dair önemli ipuçları vermektedir. Gelecekte, bu tür modellerin daha da büyüyerek, daha geniş veri setleri üzerinde eğitilmesi ve daha güçlü sonuçlar üretmesi beklenmektedir. Bunun yanı sıra, önyargı ve adil öğrenme gibi konuların da daha fazla ele alınacağı bir döneme giriyoruz. Büyük dil modelleri, eğitim süreçlerinde kullanılan veri setlerindeki önyargılardan etkilenebilir ve bu da modelin çıktılarına yansıyabilir. Gelecekte, MT-NLG ve benzeri modellerin daha adil ve tarafsız bir şekilde öğrenmesi için yeni yöntemler geliştirilecektir.

Ayrıca, bu tür büyük dil modellerinin enerji tüketimi ve hesaplama maliyetleri de önemli bir tartışma konusu olmaya devam edecek. Çok büyük dil modellerinin eğitimi ve kullanımı, büyük miktarda enerji gerektirir ve bu da çevresel etkileri gündeme getirir. Gelecekte, daha çevre dostu ve verimli model eğitimi yöntemlerinin geliştirilmesi, bu alanda önemli bir adım olacaktır.

Sonuç olarak, Megatron-Turing NLG modeli, doğal dil işleme alanında devrim niteliğinde bir adım olarak karşımıza çıkıyor. Gelişmiş dil anlayışı ve üretim yetenekleri sayesinde birçok sektörde dönüşüm yaratma potansiyeline sahip olan bu model, yapay zekâ dünyasında yeni bir çağın kapılarını aralıyor. Gelecekte, bu tür büyük dil modellerinin daha da gelişerek, insanlarla daha derin ve anlamlı bir etkileşim kurması bekleniyor.