Doğal dil işleme (NLP) alanında yaşanan en önemli gelişmelerden biri, 2017 yılında Google araştırmacıları tarafından sunulan Transformer algoritmasıdır. Bu algoritma, dil modellerinin eğitimini ve performansını köklü bir şekilde değiştirdi. Peki, Transformer algoritması nasıl ortaya çıktı, işleyiş prensipleri nelerdir ve günümüzdeki yeri nedir? Bu soruları yanıtlamak üzere detaylı bir inceleme yapalım.

TRANSFORMER ALGORİTMASININ ORTAYA ÇIKIŞI

Transformer algoritması itarihinde lk defa, 4 Aralık 2017 NeurIPS'de (Neural Information Processing Systems) yayınlanan "Attention is All You Need" başlıklı makalede tanıtıldı. Ashish Vaswani ve arkadaşları tarafından çalışmada tanıtılan algoritma doğal dil işleme alanında devrim yaratarak, önceki yöntemlerin sınırlamalarını aşma hedefi güdüyordu. Özellikle, RNN (Recurrent Neural Network) ve LSTM (Long Short-Term Memory) gibi modellerin uzun dizileri işlemekte yaşadığı güçlükler, Transformer ile ortadan kaldırıldı.

Transformer algoritmasının en önemli yeniliklerinden biri, "dikkat mekanizması"nı kullanmasıdır. Bu mekanizma, modelin kelimeler arasındaki ilişkileri daha etkili bir şekilde öğrenmesine olanak tanır. Transformer, tamamen paralel işleme yeteneğine sahip olduğu için, büyük veri setlerini çok daha hızlı bir şekilde işleyebilir.

Dikkat Mekanizması: Yapay zekânın dönüşüm noktası

Dikkat Mekanizması: Yapay zekânın dönüşüm noktası

TRANSFORMER'IN İŞLEYİŞ PRENSİBİ

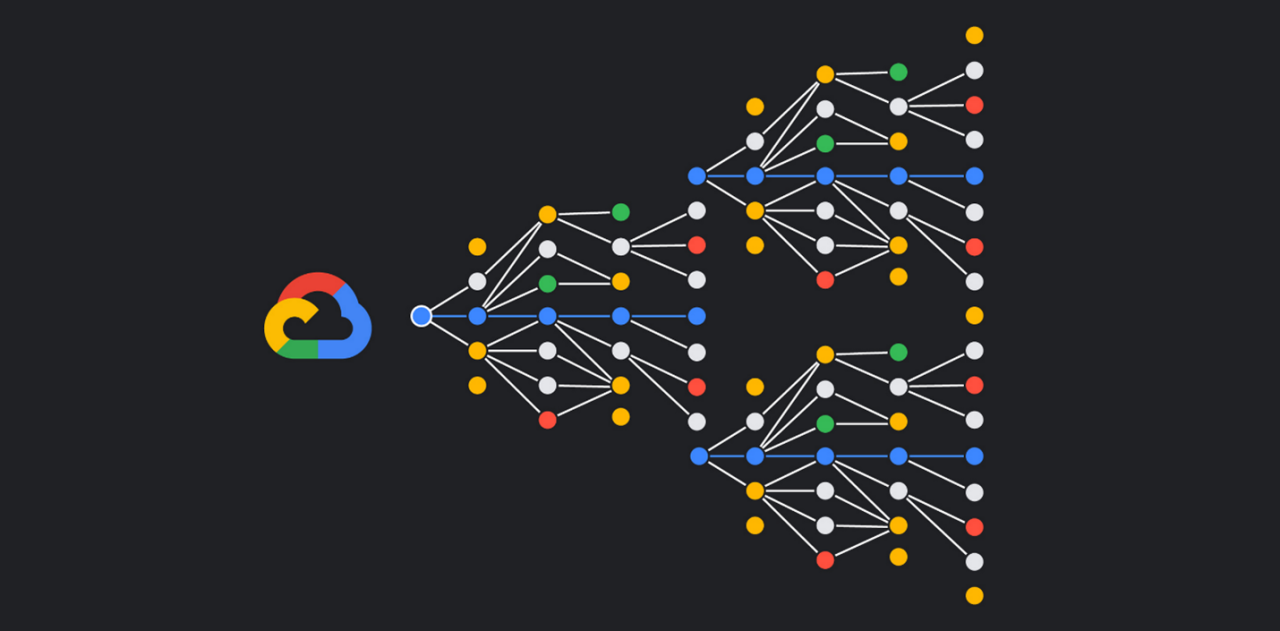

Transformer, iki ana bileşenden oluşur: Encoder (Kodlayıcı) ve Decoder (Çözücü). Bu bileşenler, sırasıyla girdi verilerini işlemek ve çıktı verilerini oluşturmak için tasarlanmıştır. İşleyiş prensibi genel hatlarıyla şu şekildedir:

1. Encoder Bileşeni

Encoder, girdi metnini işler ve bu metni sayısal bir temsil haline getirir. Her kelime, bir "embedding" (gömülü) vektörüne dönüştürülür. Bu vektörler, kelimelerin anlamını ve bağlamını temsil eder. Encoder, bu gömülü vektörler üzerinde birkaç ardışık işlem gerçekleştirir:

Self-Attention: Bu mekanizma, her kelimenin diğer kelimelerle olan ilişkisini dikkate alır. Örneğin, "Ben bir elma yedim" cümlesindeki "elma" kelimesinin bağlamını anlamak için model, "yedim" kelimesine olan ilişkiye dikkat eder.

Feedforward Ağları: Self-attention'dan sonra, veriler bir tam bağlantılı (fully connected) katmana yönlendirilir. Bu katman, her bir kelime için ayrı bir dönüşüm uygular.

Katman Normalizasyonu ve Artık Bağlantılar: Bu adımlar, modelin daha hızlı öğrenmesine ve daha iyi performans göstermesine yardımcı olur.

Encoder, girdi cümlesinin tüm kelimeleri için bu işlemleri tamamladıktan sonra, cümlenin genel bağlamını temsil eden bir vektör dizisi oluşturur.

2. Decoder Bileşeni

Decoder, encoder'dan gelen çıktıyı alır ve hedef metni üretir. Decoder, encoder'dan aldığı bilgileri kullanarak aşağıdaki adımları takip eder:

Masked Self-Attention: Decoder, çıktıyı oluştururken daha önceki kelimelere dikkat eder. Ancak, gelecekteki kelimeleri göremez; bu da modelin yalnızca geçmiş bilgileri kullanmasını sağlar.

Encoder-Decoder Attention: Bu aşamada, decoder, encoder'dan gelen çıktıya dikkat eder. Böylece, girdi metnindeki bilgiyle çıktı metni arasında bir bağ kurar.

Feedforward Ağları: Encoder'daki gibi, burada da tam bağlantılı katmanlar kullanılır.

Son olarak, decoder, son katmanında bir softmax işlevi kullanarak, olasılıklar dağılımını hesaplar ve en olası kelimeyi seçer. Bu süreç, hedef cümlenin tamamlanmasına kadar devam eder.

DİKKAT MEKANİZMASI VE AVANTAJLARI

Transformer'ın en önemli yeniliklerinden biri, "dikkat mekanizması"dır. Bu mekanizma, modelin her kelimenin bağlamını anlamasına olanak tanır. Dikkat mekanizması, her kelimenin diğer kelimelere olan dikkatini belirler ve bu sayede bağlamın daha iyi anlaşılmasını sağlar.

Dikkat mekanizmasının bazı avantajları şunlardır:

Uzun Dizi İşleme: Transformer, uzun cümleleri veya metinleri işlemek için tasarlandığı için, uzun bağıntıları modellemekte daha etkilidir.

Paralel İşleme: Geleneksel RNN ve LSTM’lerdeki sıralı işleme yerine, Transformer, tüm kelimeleri aynı anda işleyebilir. Bu, eğitim süresini önemli ölçüde kısaltır.

Ölçeklenebilirlik: Transformer mimarisi, büyük veri setleriyle etkili bir şekilde çalışabilme kapasitesine sahiptir, bu da daha büyük modellerin eğitilmesine olanak tanır.

GÜNÜMÜZDEKİ YERİ VE UYGULAMALARI

Transformer algoritması, doğal dil işleme alanında devrim yarattığı için birçok alanda kullanılmaktadır. İşte bu alanlardan bazıları:

1. Dil Modelleri

Transformer mimarisi, çok sayıda dil modelinin temelini oluşturur. Örneğin, BERT (Bidirectional Encoder Representations from Transformers), GPT (Generative Pre-trained Transformer) ve T5 (Text-to-Text Transfer Transformer) gibi modeller, Transformer’ın sunduğu avantajları kullanarak geliştirilmiştir. Bu modeller, metin üretme, anlama ve başka NLP görevlerinde olağanüstü performans sergilemektedir.

Google'ın çığır açan dil modeli: BERT

Google'ın çığır açan dil modeli: BERT

GPT: İnsansı metin üretim devriminin babası

GPT: İnsansı metin üretim devriminin babası

2. Makine Çevirisi

Transformer, makine çevirisi alanında da önemli bir yenilik sunmuştur. Google Translate gibi popüler çeviri sistemleri, Transformer mimarisini kullanarak daha doğal ve doğru çeviriler elde etmektedir. Bu sistemler, cümlelerin bağlamını daha iyi anlayarak, kelimeleri yalnızca bireysel olarak değil, cümleler içinde bir bütün olarak değerlendirir.

3. Metin Sınıflandırma ve Duygu Analizi

Transformer tabanlı modeller, metin sınıflandırma ve duygu analizi gibi görevlerde de etkili bir şekilde kullanılmaktadır. Özellikle BERT, belirli bir metnin pozitif, negatif veya nötr olup olmadığını belirlemek için yüksek doğruluk oranlarıyla kullanılabilir.

4. Görsel ve Metin Entegrasyonu

Son yıllarda, Transformer mimarisi yalnızca metinle sınırlı kalmayarak, görsel verilerin işlenmesi için de kullanılmaya başlandı. Vision Transformer (ViT), görüntü verilerini Transformer mimarisi ile işlemek için geliştirilmiştir. Bu, görsel ve metin verilerinin entegrasyonuna olanak tanır.

Gelecekteki Gelişmeler ve Zorluklar

Transformer algoritması, doğal dil işleme alanında bir dönüm noktası oluşturmuş olsa da, gelecekte karşılaşacağı zorluklar da vardır. Bunlar arasında:

Kaynak Tüketimi: Büyük modellerin eğitimi, önemli ölçüde hesaplama gücü ve enerji gerektirir. Bu, çevresel etkiler ve sürdürülebilirlik açısından endişelere yol açabilir.

Yanlılık Sorunları: Eğitim verilerinin doğası, modellerin öğrenme süreçlerinde yanlılık yaratabilir. Bu, sosyal ve etik sorunları gündeme getirir.

Modelin Şeffaflığı: LLM'lerin (Büyük Dil Modelleri) nasıl çalıştığı konusunda daha fazla şeffaflık sağlanması gerekmektedir. Kullanıcıların, bu modellerin karar alma süreçlerini anlaması önemlidir.

Yapay zekânın dil devrimi: Büyük Dil Modelleri (LLM) nedir?

Yapay zekânın dil devrimi: Büyük Dil Modelleri (LLM) nedir?

Transformer algoritması, doğal dil işleme alanında devrim yaratan bir yenilik olarak kabul edilmektedir. 2017 yılında tanıtılmasından bu yana, birçok başarılı uygulama ve modelin temelini oluşturmuş, dil anlama ve üretme yeteneklerini köklü bir şekilde değiştirmiştir. Dikkat mekanizması ve paralel işleme yetenekleri sayesinde, uzun metinleri daha etkili bir şekilde işleyebilmekte ve çok çeşitli görevlerde kullanılabilmektedir. Ancak, karşılaşılan zorlukların üstesinden gelmek için sürekli olarak gelişim ve inovasyon gerekmektedir. Gelecekte, Transformer’ın daha geniş uygulama alanlarına yayılması ve sosyal sorumluluk ilkelerine uygun olarak geliştirilmesi beklenmektedir.